설명을 해주는 안전한 인공지능

설명가능한 안전한 인공지능?

시뮬레이션이 아닌 현실 세계에서 인공지능을 적용하려면 필수로 고려해야할 점은 “안전성” 입니다. 오늘은 보다 안전한 인공지능을 만들기 위한 방법을 알아보도록 하겠습니다.

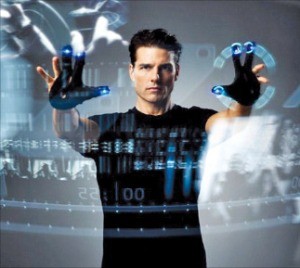

1984년에 나온 영화 ‘터미네이터’시리즈는 인공지능이 인간들을 죽이고 지배하는 것을 막기위해 인간측 반군이 싸우는 것을 다룬 영화입니다.

이 영화는 총 6개의 시리즈가 나올 정도로 굉장히 인기있는 영화입니다. 저도 어렸을때 터미네이터가 “I will be back”했던 장면이 떠오르는데요.

터미네이터 1편이 나오고 35년이 지난 지금, 인공지능이란 단어는 일상생활에서 거의 매일 접할 정도로 친숙한 단어가 되었습니다. 그럼에도 불구하고 인공지능에 대한 공포감을 소재로 한 영화, 드라마가 꽤 많이 나오고 있습니다.

그러한 영화,드라마의 내용으로는 인공지능이 목표를 달성하기 위해서 인간의 시점으로 보았을때 도덕적이지 않은 행동을 서슴치 않고 하는 것에 관한 내용입니다.예를들어 지구를 지키는 것이 목표인 인공지능이 인류가 지구를 지키는데 가장 해가 된다고 판단하고 인류를 없애려고 하는 것이죠.

최근 인공지능의 학습법으로 많이 언급되는 딥러닝도 마찬가지로 결과에 대한 “설명”을 할 수 없습니다.

딥러닝 모델은 정보를 받고 여러 레이어로 이루어져 있는 인공신경망을 거쳐 결과를 도출하는데,

“weight”라고 불려지는 인공신경망끼리의 연결이 매우 복잡하여 디러닝 모델을 통해 나온 결과의 원인알려져 있지 않기 때문에 “블랙박스”라고 부르기도 합니다.

<출처 :https://medium.com/@14prakash/back-propagation-is-very-simple-who-made-it-complicated-97b794c97e5c>

인공지능 학습 방법 중 한가지인 강화학습은 에이전트가 가능한 모드 행동 중에서 보상을 가장 많이 받는 행동을 선택합니다.

강아지가 먹이를 먹기 위해 “앉아”, “손”을 하는 것처럼요.

알파고의 학습방법으로 널리 알려진 이 강화학습에도 딥러닝 모델을 사용해 행동들의 가치를 판단하기 때문에, 마찬가지로 결과에 대한 이유를 정확히 알 수 없습니다.

최근 인공지능을 산업에 적용하는 시도가 계속 이루어지고 있습니다.

챗봇으로 상담원을 대신하여 인건비를 줄이고, 자율주행자동차로 운전자가 자동차 운행을 하며 뺏기는 코스트를 줄이기도 하고, 공장에서는 양품/불량품을 선발하기도 합니다. 또 물류 이동으로 쓰이기도 하죠.

이렇게 인공지능이 현실에서 사용될 때 안전성은 매우 중요한 키워드 입니다.

1년전 Uber의 자율주행자동차가 사람을 치는 사고가 났지만 원인을 명확하게 알 수 없었습니다.

[ ](http://www.youtube.com/watch?v=ufNNuafuU7M “”)

](http://www.youtube.com/watch?v=ufNNuafuU7M “”)

인공지능연구는 군사에서도 진행 되고 있습니다.

그 중 적의 전투기 격추를 위해 학습된 인공지능의 연구 또한 되고 있습니다.

https://phys.org/news/2019-05-ai-dogfight.html

이렇게 살상능력을 가진 인공지능이 연구되고 있다니…. 무섭네요.

어때요. 들어보니 뭔가… 전에 말한 인공지능 영화가 실제로 일어날 수 있다는 생각이 들지 않나요?

미래에는 목표를 달성하기 위해 윤리를 무시한 인공지능이 어쪄면 있을지도 모른다는 무서운 생각이 듭니다.

이런 위험을 방지하기 위해 최근 인공지능의 안전성에 대해서 많이 연구가 되고 있습니다.

실제로 잘 쓰이기 위해서는 꼭 Safe AI 에 대해서 연구가 되어야겠죠.

이 분야로 최근 연구되고 있는데 이걸 Explainable AI(XAI)라는 용어로 부릅니다.

딥러닝 모델을 통한 결과가 “왜” 나왔는지에 대해 “설명”을 하는 연구인데요.

예를 들면 기존 방법은 고양이를 입력으로 받은 딥러닝 모델은 이 동물이 고양이일 확률을 알 수 있습니다.

단순 classification 문제가 아닌 좀 더 복잡한 문제에 대한 의사결정일때 딥러닝 모델에 대한 신뢰도를 고려할 수 있죠.

예를 들면, 트롤리 딜레마 입니다.

” 열차가 선로를 따라 달리고 있고, 선로 중간에서는 인부 다섯 명이 작업을 하고 있습니다. 그리고 당신 손에는 열차의 선로를 바꿀 수 있는 전환기가 있습니다. 다섯 사람을 구하기 위해서 선로를 바꾸는 전환기를 당기면 되지만, 불행하게도 다른 선로에는 인부 한 명이 작업을 하고 있는 중입니다. 다섯 명을 살리기 위해서는 선로 전환기를 당기면 되지만, 전환기를 당길 경우 다른 선로에 있는 인부 한 명은 죽게 됩니다. 이는 다섯 명을 살리기 위해 한 명을 희생시키는 행위가 도덕적으로 허용될 수 있는지를 묻는 윤리학 실험입니다.” (Right brain lab)

이런 경우에는 “확률” 보다 “왜”이 결정을 내렸는지에 대해 꼭 설명이 되어야하죠.

XAI 에서는 결과가 단지 “고양이일 확률”이 아닌 이 고양이는 털이 있고 귀가 뾰족하고 네개의 발이 있는 특징을 가졌기에 고양이다. 라고 결과가 나오는 것이죠.

또한 감정인식을 할때도 “ 이 얼굴은 화난 얼굴이다.” 왜냐하면 학습할때 화난 얼굴이라고 분류되어 있는 다른 얼굴들과 비슷하기 때문이다. 라고 설명을 해주는 것이죠.

(출처 : DARPA)

(출처 : DARPA)

이렇게 설명이 가능하다면, 인공지능이 바로 의사결정을 내리는 것이 아닌 사용자가 인공지능이 내린 결정, 설명을 보고 의사결정을 할때 “참고”하여 더 나은 의사결정을 할 수도 있습니다.

현실세계에 인공지능이 적용될때 곡 고려해야할, 설명가능한 인공지능은 현재 활발하게, 여러분야에서 연구되고 있으며 방법 또한 많습니다. 여기서 모든 방법을 다루지는 않을 것이고 추천 논문 링크를 아래에 넣어 놓을테니 더 궁금하신 분은 논문을 살펴보시면 좋을 것 같습니다!

1. Explaining Deep Model via Attribution: Method and Evaluation

– Intro : Explaining Explanations: An Overview of Interpretability of Machine Learning

https://arxiv.org/abs/1806.00069

2. Methods

– Zhang, Quanshi, Ying Nian Wu, and Song-Chun Zhu. ‘Interpretable convolutional neural networks.’ CVPR. 2018.

– Wagner, Jorg, et al. ‘Interpretable and Fine-Grained Visual Explanations for Convolutional Neural Networks’ CVPR. 2019.

3. Evaluations

– Adebayo, Julius, et al. ‘Sanity checks for saliency maps.’ NIPS. 2018.

– Yang, Mengjiao, and Been Kim. ‘BIM: Towards Quantitative Evaluation of Interpretability Methods with Ground Truth.’ arXiv preprint arXiv:1907.09701 (2019).

References

http://blog.rightbrain.co.kr/?p=9003

https://www.darpa.mil/attachments/XAIProgramUpdate.pdf

https://www.cc.gatech.edu/~alanwags/DLAI2016/(Gunning)%20IJCAI-16%20DLAI%20WS.pdf

Interpretable and Fine-Grained Visual Explanations for Convolutional Neural Networks

http://openaccess.thecvf.com/content_CVPR_2019/papers/Wagner_Interpretable_and_Fine-Grained_Visual_Explanations_for_Convolutional_Neural_Networks_CVPR_2019_paper.pdf